Kurz und Knapp

- Digitale Sprachassistenten, medizinische Diagnostik oder autonomes Fahren: Algorithmen der Künstlichen Intelligenz (KI) sind mittlerweile Bestandteil des täglichen Lebens.

- Doch wie kommen KI-Systeme zu ihren Einschätzungen? Handelt es sich wirklich um intelligente Entscheidungen oder statistisch erfolgreiche Verfahren?

- Mit einer neuen Technologie wird für Forscherinnen und Forscher erstmals sichtbar, auf welche Weise KI-Systeme ihre Entscheidungen treffen.

Neue Technologie analysiert, wie „intelligent“ KI-Systeme wirklich sind

Eingesetzt wurde hier eine von der TU Berlin und dem HHI entwickelte Technik, die „Layer-wise Relevance Propagation“ (LRP). Diese macht sichtbar, aufgrund welcher Kriterien KI-Systeme Entscheidungen treffen. „Insbesondere in der medizinischen Diagnostik oder in sicherheitskritischen Systemen dürfen wir keine KI-Algorithmen mit unsicheren Problemlösungsstrategien oder sonstige KI-Schummel-Kandidaten einführen“, sagt Klaus-Robert Müller, Professor für Maschinelles Lernen an der TU Berlin.

Mit dem neuen Verfahren wurden die KI-Systeme nicht nur getestet, sondern auch quantifiziert: Vom naiven Problemlösungsverhalten, über Schummel-Strategien bis hin zu „intelligenten“ strategischen Lösungsansätzen. Das Forscherteam war überrascht von der großen Bandbreite der gelernten Problemlösungsstrategien.

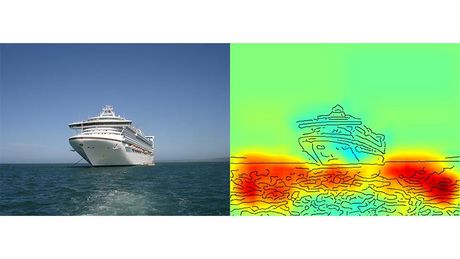

So verfolgte ein preisgekröntes KI-System zur Klassifikation von Bildern eine aus menschlicher Sicht naive Lösungsstrategie: Es klassifizierte Bilder vorwiegend anhand des Kontextes. Dabei wurden Bilder der Kategorie „Schiff“ zugeordnet, wenn viel Wasser im Bild zu sehen war. Die eigentliche Aufgabe, nämlich Schiffe zu erkennen, hat es nicht gelöst – auch wenn es die Mehrzahl der Bilder am Ende korrekt klassifiziert hat.

Auch einige der neuesten KI-Algorithmen, die sogenannten tiefen neuronalen Netzwerke, nutzten eine fehlerhafte Lösungsstrategie. Sie stützten ihre Klassifikationsentscheidung auf Daten, die während der Präparation der Bilder entstanden waren und mit dem eigentlichen Bildinhalt nichts zu tun hatten.

„Solche KI-Systeme sind für den praktischen Einsatz völlig unbrauchbar. Ihr Einsatz in der medizinischen Diagnostik oder in sicherheitskritischen Bereichen birgt sogar enorme Gefahren“, sagt Klaus-Robert Müller. Er schätzt, dass etwa die Hälfte der aktuell eingesetzten Systeme implizit oder explizit eine solch fehlerhafte Strategie nutzen könnte. Man müsse diese systematisch überprüfen, damit sichere KI-Systeme entwickelt werden können.

Das Forschungsteam identifizierte aber auch Systeme, die über unerwartet „intelligente“ Strategien verfügten. Einige KI-Systeme hatten gelernt, die Atari-Spiele „Breakout“ und „Pinball“ zu spielen. Sie haben „ganz klar das Konzept des Spiels ‚verstanden‘ und einen intelligenten Weg gefunden, zielgerichtet und risikoarm sehr viele Punkte zu sammeln“, sagt Wojciech Samek, Gruppenleiter am Fraunhofer HHI.

Die automatisierte Technik ist Open Source und steht allen Wissenschaftlern und Wissenschaftlerinnen zur Verfügung. Die Forschungsergebnisse wurden in Nature Communications veröffentlicht.

14.03.2019

in Kooperation mit dem