Astrophysikerinnen und Astrophysiker können mittlerweile recht genau vorhersagen, wie ein einzelner Stern entsteht, lebt und vergeht. Die meisten der Himmelskörper beeinflussen sich aber gegenseitig. Darum braucht es neue Theorien und Erklärungsmodelle, die sich nur schwer testen lassen: Beobachtungsdaten sind begrenzt verfügbar und Experimente mit Sternen schier unmöglich. Zumindest in der Realität. Denn per Supercomputer können wir Sternsysteme und die von ihnen verursachten Phänomene simulieren sowie besser verstehen. Ein praktikabler aber anspruchsvoller Ansatz. Hunderttausende Recheneinheiten müssen koordiniert, die Arbeitslast der Simulation gleichmäßig auf Prozessorkerne oder Grafikkarten verteilt werden. Die individuellen Recheneinheiten selbst sollen dabei möglichst effizient genutzt werden.

Wie Superrechner die Sterne ins Labor holen

Ein Gastbeitrag von Prof. Dr. Dirk Pflüger und Gregor Daiß

Wenn selbst Superrechner an Grenzen stoßen...

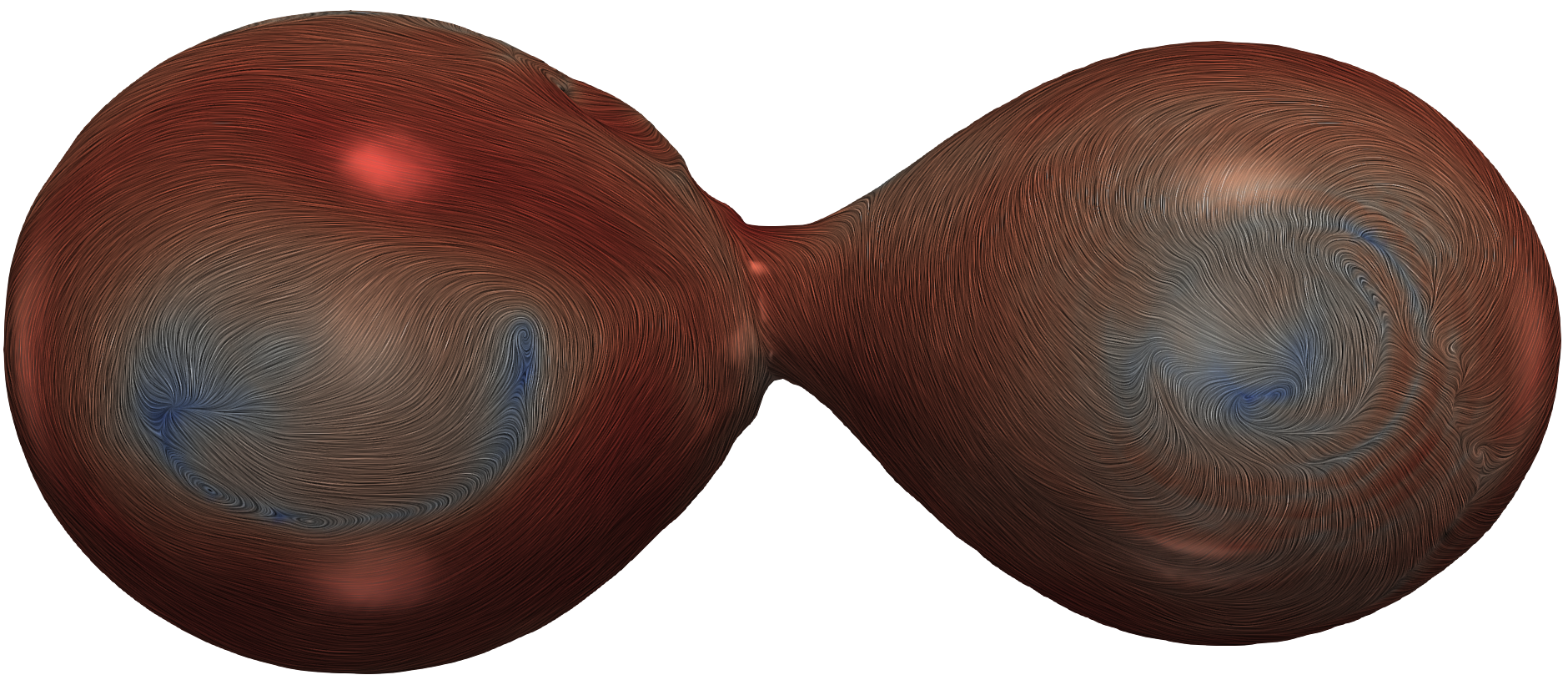

Damit nicht genug. Unterschiedliche Supercomputer beinhalten häufig sehr unterschiedliche Hardware. Die Simulationen müssen also von Forschenden manuell und mühselig auf den jeweils genutzten Supercomputer angepasst werden. Bis eine große Simulation angepasst ist, steht schon die nächste Hardware-Generation ins Haus. Gerade für Projekte mit kleineren Forscherteams stellt dies oft ein großes Problem und eine stete Quelle an Frustration dar. Wie das einfacher geht, haben wir am Fallbeispiel Octo-Tiger analysiert – das ist der Name einer Astrophysiksimulation zur Erforschung von Binärsternsystemen. Hierbei haben wir verschiedene Ansätze und Strategien untersucht, um überhaupt erst große, relevante Simulationen durchzuführen. Denn selbst die schnellsten Rechner der Welt kommen an ihre Grenzen, wenn zwei Sternensysteme unterschiedlicher Größe verschmelzen. Im Detail betrachtet die Lösung, wie sich riesige Massen bewegen und welche Wechselwirkungen mit Gravitation und Strahlung stattfinden.

...braucht es eine plattformunabhängige Orchestrierung...

Um dennoch rasch Ergebnisse zu liefern, muss die ganzheitliche Fragestellung clever in zahlreiche kleinere Probleme zerlegt und effizient auf unterschiedliche Hardwarekomponenten verteilt werden. Diese plattformunabhängige Orchestrierung gilt als eine der großen Herausforderungen von parallelem und verteiltem Rechnen. Die ausgefeilte Kombination existierender Methoden, deren Verbesserung sowie die Entwicklung völlig neuer Lösungsansätze hat uns zu einem effizienten Ausführungsmodell geführt. Damit können nun Simulationen entwickelt werden, die auf unterschiedlichen Supercomputern laufen. Und dies hoffentlich auch auf der nächsten Generation an Rechnern.

…für schnellere Simulationen

Für die Simulation von binären Sternensystemen mit Octo-Tiger hat dies bereits zu signifikant schnelleren Simulationen geführt, und wir arbeiten im Augenblick mit unseren Kolleginnen und Kollegen aus der Astrophysik der Louisiana State University daran, Simulationen mit realen Beobachtungen des OGLE Teleskops abzugleichen. Unsere hierzu entwickelten Beiträge und das Ausführungsmodell könnten zukünftig nicht nur genutzt werden, um Himmelskörper besser zu verstehen – denn natürlich lassen sich auch ganz irdische Probleme auf Superrechnern simulieren.

Die hier veröffentlichten Inhalte und Meinungen der Autorinnen und Autoren entsprechen nicht notwendigerweise der Meinung des Wissenschaftsjahres 2023 – Unser Universum.

Weitere Infos

Hier finden sie die Original-Veröffentlichung.

Erfahren Sie hier mehr zum Insitut für Parallele und Verteilte Systeme (IPVS).

Prof. Dr. Dirk Pflüger

Dirk Pflüger leitet seit 2018 die Abteilung Scientific Computing am Institut für Parallele und Verteilte Systeme. Er war mehrere Jahre Vorstandsmitglied des Informatik-Forum Stuttgart e.V. (infos) und ist zudem Alumnus der Jungen Akademie an der Berlin-Brandenburgischen Akademie der Wissenschaften und der Nationalen Akademie der Wissenschaften Leopoldina.